ユーザー定義のモーション登録と編集を支援するシステム

A Cross-Modal Operable Motion-Learning System Combined with Virtual Avatar and Auditory Feedback

2021

Chengshuo Xia, Xinrui Fang, Riku Arakawa, Yuta Sugiura

Chengshuo Xia, Xinrui Fang, 荒川陸, 杉浦裕太

[Reference /引用はこちら]

Chengshuo Xia, Xinrui Fang, Riku Arakawa, and Yuta Sugiura. 2022. VoLearn: A Cross-Modal Operable Motion-Learning System Combined with Virtual Avatar and Auditory Feedback. Proc. ACM Interact. Mob. Wearable Ubiquitous Technol. 6, 2, Article 81 (July 2022), 26 pages.[DOI][Presentation video]

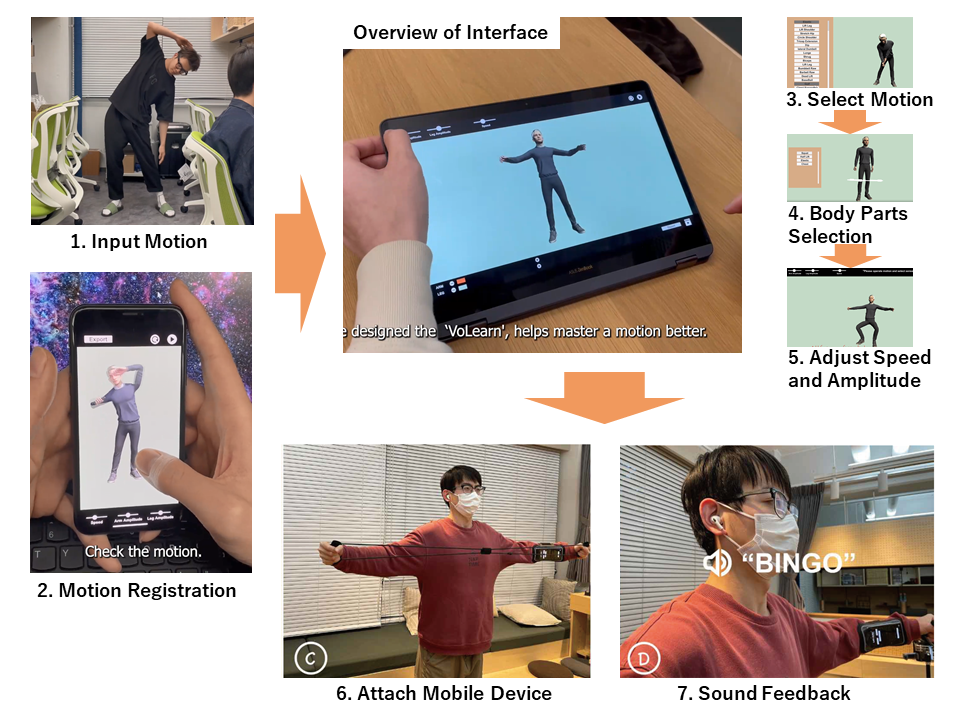

従来のモーション教示システムは、主に事前定義された動作と視覚に基づくフィードバックに依存しており、適用シーンが限定され、さらに専用のデバイスが必要であった。本研究では、ユーザが定義したモーションを効果的に学習するためのシステムVoLearnを提案する。本システムは、RGB動画映像から任意のモーションを取り込み、バーチャル環境上でそのモーションを3Dアニメーション化する。入力されたモーションに対して、手足の速度や振幅を制御できる操作インタフェースを提供する。身体部位の回転情報を出力することで、ユーザは日常的に使用するデバイス(スマートフォン)をウェアラブルデバイスとして利用し、聴覚フィードバックを得ながら時間・振幅の両方のフィードバックに従って訓練・実践することができる。ユーザ調査により、本システムが動作学習の振幅誤差や時間誤差の低減に役立つことが実証された。

Conventional motion tutorials rely mainly on a predefined motion and vision-based feedback that normally limits the application scenario and requires professional devices. In this paper, we propose VoLearn, a cross-modal system that providesoperability for user-defined motion learning. The system supports the ability to import a desired motion from RGB video and animates the motion in a 3D virtual environment. We built an interface to operate on the input motion, such as controlling the speed, and the amplitude of limbs for the respective directions. With exporting of virtual rotation data, a user can employ a daily device (i.e., smartphone) as a wearable device to train and practice the desired motion according to comprehensive auditory feedback, which is able to provide both temporal and amplitude assessment. The user study demonstrated that the system helps reduce the amplitude and time errors of motion learning. The developed motion-learning system maintains the characteristics of high user accessibility, flexibility, and ubiquity in its application.