角膜反射画像を利用したホバー入力インタフェース

Hover Interface using Corneal Reflection Images Captured by Smartphone Front Camera

2025

中村裕大,池松香,高柳直歩,加藤邦拓,杉浦裕太

Yudai Nakamura, Kaori Ikematsu, Naoto Takayanagi, Kumihiro Kato, Yuta Sugiura

[引用はこちら/Reference]

Yudai Nakamura, Kaori Ikematsu, Naoto Takayanagi, Kunihiro Kato, and Yuta Sugiura. 2025. ReflecTrace: Hover Interface using Corneal Reflection Images Captured by Smartphone Front Camera. In Adjunct Proceedings of the 38th Annual ACM Symposium on User Interface Software and Technology (UIST Adjunct ’25), September 28-October 1, 2025, Busan, Republic of Korea, ACM, New York, NY, USA, 3 pages. [DOI]

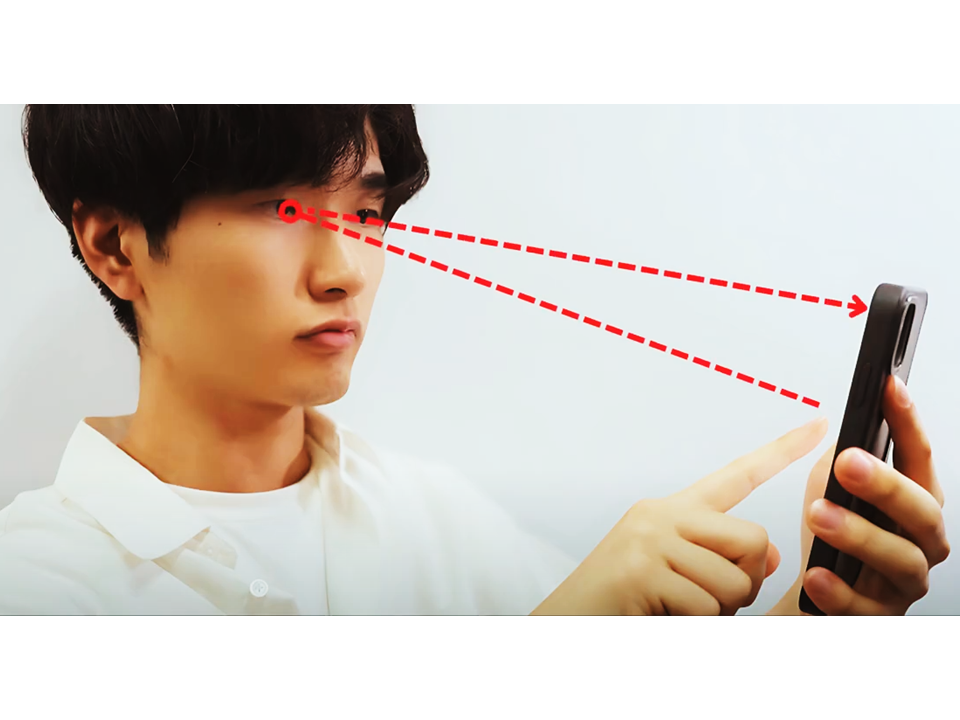

本研究では、スマートフォンに内蔵された前面カメラで取得した角膜反射画像を用いて、画面上の指のホバー入力を検出する手法を提案する。本手法は外部センサや追加ハードウェアを一切必要とせず、前面カメラでは直接撮影できない画面近傍空間における指位置の検出を可能にする。提案手法では、畳み込みニューラルネットワーク(CNN)を用いてホバーしている指の二次元位置を推定し、あらかじめ定義したグリッドのどのセル上に位置しているかを判定する。実験の結果、提案モデルは異なるグリッド設定においても二次元位置推定で高い精度を達成し、2×2のような粗いグリッドでは90%以上、最大5×5までの細かい分割でも80%以上を維持し、その頑健性と適応性を示した。

"We propose a method to detect finger hover input on a smartphone screen using corneal reflection images captured by its built-in front-facing camera. This method requires no external sensors or additional hardware and enables the detection of finger positions in the near-screen space that cannot be directly captured by the front camera. We use a convolutional neural network (CNN) to estimate the 2D position of a hovering finger and identify which cell in a predefined grid is being hovered over. Our model achieved high accuracy in 2D position estimation across different grid settings, exceeding 90 percent with coarse grids such as 2x2 and maintaining over 80 percent even with finer divisions up to 5x5, demonstrating its robustness and adaptability."