[Reference /引用はこちら]

Katsutoshi Masai, Kai Kunze, Daisuke Sakamoto, Yuta Sugiura, Maki Sugimoto, Face Command — User-defined Facial Gestures on Smart Glasses, International Symposium on Mixed and Augmented Reality 2020(ISMAR 2020), IEEE, 374-386. [DOI]

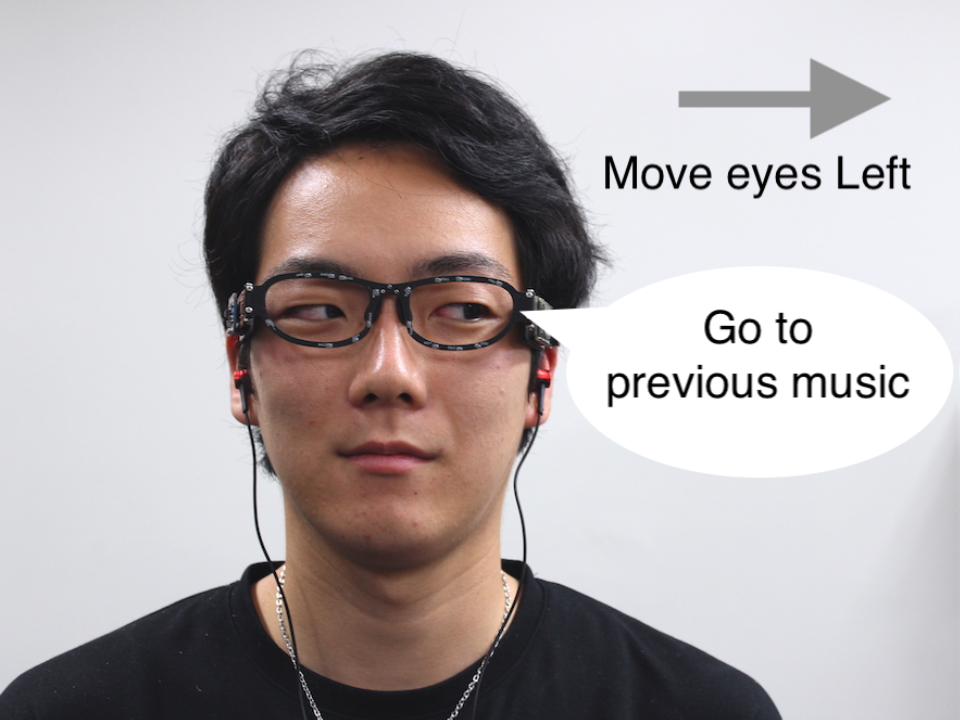

拡張現実感(AR)のために、顔、目、頭の動きを利用した顔関連ジェスチャの利用を提案する。この技術を用いることで、ハンズフリーで目立たないインタラクションを介してコンピュータシステムを利用することが可能となる。日常におけるスマートホームの文脈での顔関連ジェスチャの適切な使用を探るためにユーザ定義による実験(Amazon Mechanical Turkを使用、N = 37)をした。提案されたジェスチャについての特性(複雑さ、ジェスチャ/タスク間の関連付け)、と最終的なユーザー定義のジェスチャセットについて報告する。また、スマート眼鏡を使用して、日常生活での利用を考慮したジェスチャ検出可能性の検証(N = 13)を実施した。装置には16個の光学センサと慣性計測ユニット(IMU)が搭載されている。この装置は、将来的には光学シースルーディスプレイに組み込むことができる。実験の結果、畳み込みニューラルネットワーク(CNN)を用いて、8つの動的な顔関連ジェスチャを平均F1スコア0.911で検出できた。また、ユーザーに依存しないトレーニングの結果と、実験者がジェスチャのうち2つのジェスチャをテストした1時間の記録を報告する。

We propose the use of face-related gestures involving the movement of the face, eyes, and head for augmented reality (AR). This technique allows us to use computer systems via hands-free, discreet interactions. In this paper, we present an elicitation study to explore the proper use of facial gestures for daily tasks in the context of a smart home. We used Amazon Mechanical Turk to conduct this study (N = 37). Based on the proposed gestures, we report usage scenarios and complexity, proposed associations between gestures/tasks, a user-defined gesture set, and insights from the participants. We also conducted a technical feasibility study (N = 13) with participants using smart eyewear to consider their uses in daily life. The device has 16 optical sensors and an inertial measurement unit (IMU). We can potentially integrate the system into optical see-through displays or other smart glasses. The results demonstrate that the device can detect eight temporal face-related gestures with a mean F1 score of 0.911 using a convolutional neural network (CNN). We also report the results of user-independent training and a one-hour recording of the experimenter testing two of the gestures.