耳の入力インタフェース化

Turning the Ear into an Input Surface

2017

菊地高史,杉浦裕太,正井克俊,杉本麻樹,トーマスブルース

Takashi Kikuchi, Yuta Sugiura, Katsutoshi Masai, Maki Sugimoto, Bruce H. Thomas

[Reference /引用はこちら]

Takashi Kikuchi, Yuta Sugiura, Katsutoshi Masai, Maki Sugimoto, Bruce H. Thomas, EarTouch: Turning the Ear into an Input Surface, In Proceedings of the 19th International Conference on Human-Computer Interaction with Mobile Devices and Services (MobileHCI ’17). ACM, New York, NY, USA, Article 27, 6 pages. [DOI]

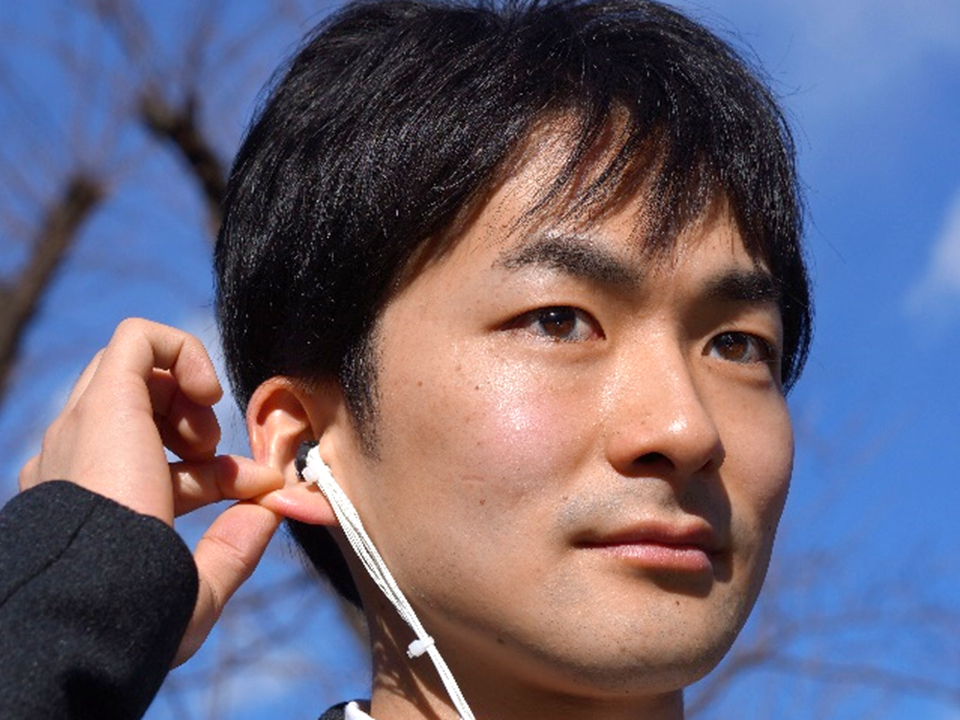

本研究では、イヤフォンとしては従来のサイズを保ちつつ、イヤフォンとワンパッケージになり、多様な入力を実現する方法として耳自体を入力面として利用する方法を提案する(図1)。この方法では、イヤフォンにいくつかの光センサを装着する。耳の皮膚変形を光センサで計測することで、耳全体の変形を推定する。本手法で利用する光センサは反射型の光センサであり、これは赤外光を発光して、その反射光の強度を取得することで対象物の距離を計測できるセンサである。これをイヤフォンに装着して耳内の皮膚までの距離を複数点で計測すると変形形状が取得できる。取得したセンサデータを用いて、SVMによりジェスチャ識別をする。これで耳を上下左右に軽く引っ張るようなジェスチャが認識できる

We propose EarTouch, a new sensing technology for ear-based input for controlling applications by slightly pulling the ear and detecting the deformation by an enhanced earphone device. It is envisioned that EarTouch will enable control of applications such as music players, navigation systems, and calendars as an “eyes-free” interface. As for the operation of EarTouch, the shape deformation of the ear is measured by optical sensors. Deformation of the skin caused by touching the ear with the fingers is recognized by attaching optical sensors to the earphone and measuring the distance from the earphone to the skin inside the ear. EarTouch supports recognition of multiple gestures by applying a support vector machine (SVM). EarTouch was validated through a set of user studies.